Inteligência artificial emocional e a economia da empatia

Nós realmente queremos escalar o acesso ao nosso subconsciente e quantificar nossas emoções?

Nós realmente queremos escalar o acesso ao nosso subconsciente e quantificar nossas emoções?

19 de março de 2021 - 15h37

À medida que o festival avança vamos formando uma visão mais clara sobre os principais tópicos que permeiam as discussões. Com certeza esse ano já podemos destacar a importância da ética e empatia como pilares para a inovação human driven. Mas fica a dúvida se a discussão chega de fato até a esfera política e social e se a regulação consegue acompanhar o ritmo da inovação ou se o compromisso das empresas é abrangente o suficiente para assumir a responsabilidade sobre questões como privacidade, especialmente quando falamos de inteligência artificial.

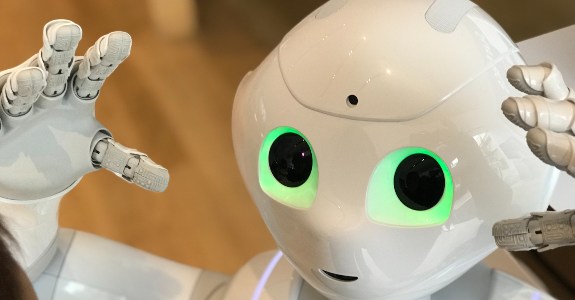

A sessão The future of Emotion AI and the Empathy Economy me chamou a atenção sobre esse assunto ao trazer para a pauta a tecnologia de inteligência artificial emocional apresentada pela Dr. Rana el Kaliouby, Co-Founder & Chief Science Officer da Affectiva, associada a uma economia que valoriza a empatia.

(Créditos: Laura musikanski/Pexels)

A palestrante reforçou que tem como missão humanizar a tecnologia ao lhe conferir inteligência emocional partindo do pressuposto que AI já está presente em várias atividades cotidianas: assistentes pessoais, algoritmos que tomam decisões por nós, entre outras mais e por isso é preciso revisitar o contrato social entre humanos e máquinas, pois já podemos ver os impactos dessa relação em uma crise de empatia que, por causa da tecnologia (mas não exclusivamente por ela) já resulta em uma polarização e falta de confiança sobre como a inteligência artificial está sendo construída e utilizada pelas empresas.

A resposta: mais tecnologia. Porém com uma premissa mais focada nas conexões humanas e menos centrada no mainstream da produtividade através da automação, uma vez que se parte do contexto de que a tecnologia tem e continuará desempenhando um papel central nas relações humanas e em como nos comunicamos. A pandemia está aí para provar.

No último ano, como pudemos nos manter motivados, próximos ou nos comunicarmos em nossos trabalhos e relações pessoais? A tecnologia possibilitou tudo isso, mas ao mesmo tempo é difícil engajar e captar a reação das pessoas pela tecnologia e realmente estabelecer uma conexão mais profunda.

E é aí que fica perceptível o quanto a comunicação não verbal é representativa em uma interação física e o desenvolvimento de human perception AI necessário para captar alguns desses sinais, como o simples inclinar de cabeça durante uma fala indicando concordância ou interesse no que está sendo dito.

Para a Affectiva a aplicação é data driven e busca quantificar emoções humanas através de deep learning a fim de resolver esses problemas. Basicamente usam câmeras e sensores para mapear expressões e combinam machine learning com um estudo aprofundado sobre emoções e expressões faciais para classificá-las.

As aplicações propostas pela empresa são inúmeras. Uma das primeiras foi em terapias para crianças com TEA (Transtorno do Espectro Autista), uma vez que pessoas no espectro apresentam dificuldade em relação a comunicação não verbal e contato visual. O projeto desenvolvido durante a passagem da Dr. Kaliouby no MIT utilizou Google Glass para ler as expressões das pessoas interagindo com as crianças e passando a elas um feedback em tempo real, melhorando seus níveis de interação.

Outras aplicações mencionadas foram em analytics e pesquisa, permitindo a leitura de reações de um participante a um anúncio ou conteúdo streaming, por exemplo, e associar isso a métricas de ações tomadas sobre aquele conteúdo (viralidade, intenção de compra, brand perception/ loyalty, etc) ou para testes de usabilidade também, captando as reações durante a navegação em uma plataforma, identificando pontos onde surgem dificuldades na experiência.

Há também a proposta de uso direcionado ao trabalho, com aplicação em call centers, por exemplo, buscando identificar níveis de stress nos funcionários, entender quem está motivado ou estressado. Melhorando a experiência do cliente e também do funcionário, supostamente, ao prevenir um burnout. Na indústria automotiva também propõe o monitoramento de motoristas, podendo entender se está cansado ou distraído. Tem na educação. Telemedicina. E assim a lista se estende sob a promessa de a tecnologia ajudar a quantificar e a evoluir as soft skills para o dia a dia de inúmeros profissionais.

Mas onde fica a privacidade? Como garantir o uso positivo em um ambiente de trabalho ou que não haverá bias? Será realmente uma ferramenta de empatia ou uma máscara para a vigilância da produtividade? Quais as consequências desse tipo de tecnologia, mesmo que não intencionais? O que pode dar errado?

A conversa não trouxe muitas respostas, mas reforçou desde o início o compromisso ético com a privacidade, com um direcionamento sobre como a decisão de quem terá acesso a esses dados estará nas mãos desses usuários que serão mapeados.

Será? Quantas pessoas conseguiriam dar opt-out em uma oportunidade de trabalho em um call center que venha a aplicar essa tecnologia, por exemplo?

O potencial de reimaginar como a conexão human-to-human acontece no digital é imenso; a premissa é real e interessante porquê de fato há vontade de ter essa troca mais humana pelo digital, principalmente em situações de interação remota, como esse mesmo evento em que estamos sem poder sentir como a audiência está respondendo. Mas é nítido que existe uma pauta muito importante sobre ética e privacidade.

Nós realmente queremos escalar o acesso ao nosso subconsciente e quantificar nossas emoções?

Isso é realmente ser mais humano?

Assim como muitas outras questões relacionadas a tecnologia, nem sim ou não, a resposta ficará a critério dos usos que ainda virão.

Veja também